鉴于训练语言模型的前期成本很高,对优化过程的任何非微不足道的改进都会大大减少完成训练过程所需的时间和金钱。长期以来,Adam及其变体是最先进的技术,而二阶(基于Hessian的)优化器由于其每步开销较大而很少被利用。

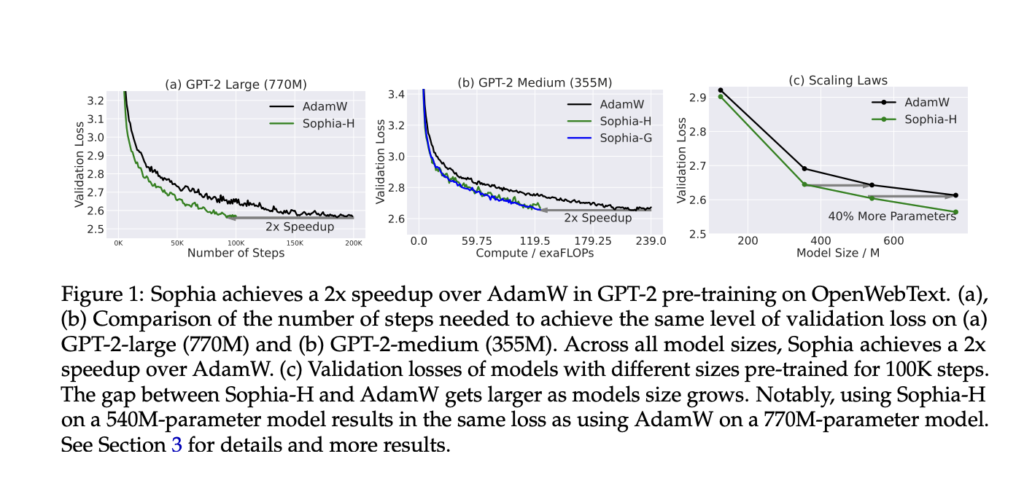

研究人员提出了一个对角线Hessian的轻量级估计,作为二阶优化器Sophia的预设条件,即二阶剪切随机优化。Sophia是一个新颖的优化器,它可以以两倍于Adam的速度解决LLMs。在更新后进行逐个元素的剪辑,通过取梯度的平均值并除以估计的Hessian的平均值来发现。剪切限制了最坏情况下的更新大小,并减轻了轨迹的非凸性和快速Hessian变化的影响。增加一些新的代码行可能会将200万美元的预算减少到100万美元的范围内(假设缩放规律适用)。

平均每步时间和内存开销都很低,因为Sophia每隔几次迭代才估计对角线Hessian。Sophia在步骤数、总计算量和壁时钟时间方面将Adam的速度提高了一倍,同时用GPT-2模型为语言建模,其规模从1.25亿到7.7亿。研究人员证明,Sophia可以适应语言建模任务所依据的大量参数变化。运行时间约束与损失的条件数无关。

在定于明天发布的代码中,研究人员使用了普遍接受的LR定义的一个略微修改版本。虽然对于打字来说比较整洁,但该论文的LR定义可能更适合计算机代码。

Sophia在Github上的库:https://github.com/Liuhong99/Sophia

在线客服

客服咨询

官方微信

返回顶部